Дубли на меге что это

Просматриваем глазами все ссылки, обращая внимание на заголовки, описания, а также URL ссылки. Составление семантического ядра: 5 типичных ошибок Послесловие. Для решения этой задачи, вы можете использовать готовые паттерны. Если вам нужно быстро удалить дубли обращайтесь в TexTerra. Дубли условно делятся на две группы: явные и net неявные. Каждый новый URL с GET-параметрами является дублем исходной страницы. Для скрытия страниц пагинации от индексации эффективней всего использовать атрибут rel"canonical" тега. Поисковикам нужно время, чтобы убрать из индекса старые адреса. Вот самые распространенные. Но она больше не поддерживается. Используем Яндекс. «Ручной» Зная особенности своей CMS, можно быстро вручную найти дубли в поисковиках. Но это актуально до момента, пока алгоритмы поисковиков не посчитают, что это было сделано намеренно, чтобы попытаться как-то манипулировать выдачей. Товары с близкими по смыслу или незначительно отличающимися характеристиками. 1/ L,R301 если файл создается с нуля, все редиректы необходимо прописывать внутри таких строк: Настройка 301 редиректа с помощью.htaccess подходит только для сайтов на Apache. Один товар на разных URL (для интернет-магазинов) Допустим, у нас интернет-магазин домен TexTerra, который продает технику кракен Apple. Попробую привести наглядный пример: магазин продает одежду, в карточке одного товара появляются вариации размера или цвета, например. Ранее для указания на главное зеркало в файле robots. После того как сканирование будет завершено, выбираем «Отфильтрованные результаты открываем раздел «Отчеты» и в пункте «Ошибки» находим все интересующие нас дубли: страниц / текста / Title / Description: Отмечу, что прорабатывать нужно только те дубли, которые отдают 200-ый код. Что нужно сделать : выгрузите список проиндексированных URL из Яндекс. В общем, правильно расставляйте приоритеты. Выглядит это следующим образом: /blog/ /blog Косая черта в конце адреса одна из самых частых причин дублей. Полные дубли содержат идентичный контент и находятся на другом url. Вторая создана специально для краулеров Google. Он должен попасть на первую страницу с контентом, чтобы начать просмотр с первой страницы и самостоятельно решать, идти ли дальше. В первом случае идем в пункт «Страницы в поиске который находится в разделе «Индексирование». Когда кто-то отвечает на комментарий к записи, CMS генерирует новый URL. Поэтому при появлении первых дубликатов рекомендуем сразу заняться анализом ситуации и их устранением! Мы познакомим вас с наиболее эффективными инструментами для решения этой важной задачи.

Дубли на меге что это - Kraken для россиян

Помните чтобы избежать дублей 404-ой, необходимо обратить внимание на все проблемные страницы. Имеется пара рабочих методов: установить на сайт модуль комментариев (например Disqus или любой другой). Автор: Ольга Коцофанэ Дубли это страницы, которые полностью или частично повторяют контент со страницы «родителя». Рассказываем, как это сделать. При отсутствии контроля за дублями, создаются дополнительные временные затраты при переобходе всех страниц. Эти параметры разделяются между собой знаком. На практике работает и канонизация страниц, и редиректы, и директивы robots. Другой способ решить проблему replytocom: открываем админку WordPress, затем идем в глобальные настройки и в пункте «Обсуждения» снимаем выделение с этого чекбокса: Если по каким-то соображениям вы не хотите пользоваться сторонними модулями и отключать классические WP-комментарии на своем сайте, то есть варианты и посложнее. Если с косой чертой, то значит можно оставить URL с / в конце, если наоборот, то оставляем адреса без /. Неявные и явные дубли страниц могут затруднять индексацию, мешать качественному SEO и усложнить работу веб-мастеру. Ваша задача найти способы, которые будут оптимальны именно в вашем случае. Для больших интернет-магазинов создание такого контента слишком затратно и долго, поэтому если выбор все же пал на этот вариант, то рекомендуется начать с тех, что приносят максимум конверсий. Пример: /price и /price. URL со слешем в конце и без него. Чтобы проверить сайт на дубли онлайн, на главной странице нужно ввести в строку URL-адрес и дождаться результатов. Уведомление о страницах с одинаковыми метатегами title и description выглядят так: Также Яндекс информирует о наличии страниц с незначащими GET-параметрами. Ручной способ нахождения дубликатов страниц прекрасно подходит для быстрого анализа сайта. А Яндекс выступает за robots. Третий способ. Если так случится, то ждать санкций долго не придется. Проверка сайта на дубли страниц онлайн предполагает использование одного из многих сервисов. Какие дубли встречаются наиболее часто Все дубли можно усредненно разделить на очевидные и неочевидные. Пример: /1 /1 Что делать : указать на главное зеркало сайта в Яндекс. Здесь есть 2 варианта: при помощи специального тега линк или плагинов. В течение 1,5 2 недель Яндекс склеит зеркала, переиндексирует страницы, и в поиске появятся только URL без WWW. Для этого нужно найти во второй части URL знак «?». Смотрите по ситуации: если проиндексировано больше страниц со слешем, оставляйте этот вариант, и наоборот.

/1 R301,L обратная операция: RewriteCond request_filename!-f RewriteCond request_URI!(. Наверх Расскажи о себе и своих интересах Для подписки на рассылку укажи свои имя и электронную почту. Последняя ситуация, которая встречается реже, использование региональных доменов с одинаковым контентом,.е. Если вы все-таки используете папки для интернет-магазина, необходимо как минимум уникализировать Title и H1, а также перемешать вывод товаров таким образом, чтобы он отличался от других страниц. Проблемы для вебмастера. Если с момента настройки https прошло менее 2 недель, не стоит бить тревогу подождите еще неделю-другую. Как предотвратить проблемы с дублированными страницами На этапе создания сайта вы можете предотвратить сканирование нежелательных URL-адресов с помощью файла robots. Также можно использовать тег canonical. Также следует запретить индексацию нежелательных страниц с помощью тега meta namerobots contentnoindex либо с помощью X-Robots-Tag: noindex в ответе сервера. Также вы сразу заметите, если URL-адреса в выдаче постоянно меняются рядом с иконкой URL появится цифра с количеством страниц, которые конкурируют за место в выдаче. Исключенных страниц. Это может усилить эффект каннибализации, но не обязательно. Если вы создаете страницы под разные города, пишите уникальный локальный контент для конкретной локации. Еще один вариант запустить поисковое продвижение сайта в SEO-модуле PromoPult. Смотрите по ситуации: если проиндексировано больше страниц со слешем, оставляйте этот вариант, и наоборот. Удаление дублей От обнаруженных дублированных страниц нужно избавиться, а также определить причины их образования и предотвратить распространение. Чаще всего появляются из-за особенностей работы. Стоит отметить, что причиной каннибализации могут быть не только дубли страниц. Как это сделать : найти в корневой папке сайта файл.htaccess и открыть (если его нет создать в формате TXT, назвать.htaccess и поместить в корень сайта прописать в файле команды для редиректа с URL со слешем на URL без слеша: RewriteCond request_filename!-d RewriteCond request_URI (. Также не стоит излишне перегружать сервер 301 редиректами, поскольку это увеличит нагрузку на него. Для каждой страницы невозможно прописать параметры индексирования лишь для групп из нескольких.

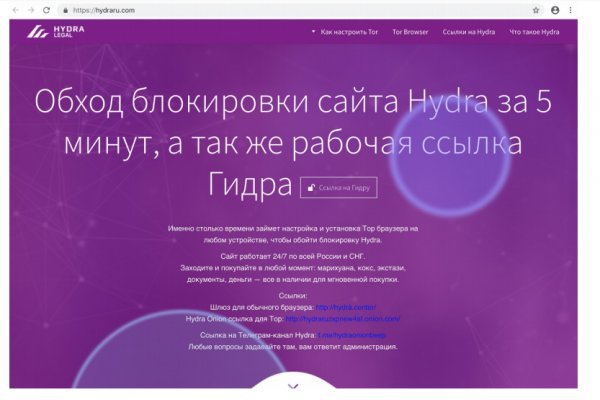

Https omg omgruzxpnew4af onion tor site